Défis courants en matière d'architecture des données

Les organisations sont souvent confrontées à des silos de données et à des connexions "point à point", où les équipes créent des connexions directes entre les sources de données et les consommateurs. Au départ, cette approche peut sembler gérable, mais au fur et à mesure que l'on ajoute des connexions et des magasins de données, le système devient un réseau enchevêtré, difficile à maintenir et fragile. Il en résulte un manque de transparence, de fiabilité et d'efficacité.

Une solution efficace consiste à adopter une architecture pilotée par les événements. De nombreuses organisations s'appuient sur Apache Kafka et Confluent Cloud pour permettre le streaming de données en temps réel. Si les architectures événementielles constituent une approche prometteuse, elles s'accompagnent de leur propre lot de défis. Sans une planification adéquate, les organisations peuvent finir par recréer le même réseau complexe de connexions qu'elles cherchaient à résoudre. Voici quelques éléments clés à prendre en compte pour une mise en œuvre réussie.

Éléments clés d'un cadre de données en temps réel réussi

1. Évolutivité et résilience

a) L'évolutivité garantit que votre plateforme de données peut évoluer avec votre organisation. L'utilisation de solutions telles que Kubernetes et d'outils d'infrastructure en tant que code (par exemple, Terraform) permet d'automatiser et de faire évoluer l'infrastructure. Le stockage hiérarchisé, qui stocke les données sur des couches chaudes (fréquemment consultées) et froides (rarement consultées), améliore encore la flexibilité en rendant les données disponibles sans coûts de stockage élevés.

b) La résilience consiste à mettre en place une infrastructure capable de faire face aux défaillances sans perte de données ou temps d'arrêt importants. La mise en place de chemins de données redondants et l'utilisation de mécanismes d'autoréparation dans des outils tels que Kafka garantissent un flux de données continu, même si des parties du système subissent des pannes.

2. Gouvernance et sécurité

a) La gouvernance des données implique la mise en place d'une validation des schémas, de contrôles d'accès et d'une gestion des métadonnées afin de garantir la qualité des données et de maintenir la cohérence entre les systèmes. L'utilisation de catalogues de données et de schémas normalisés aide les utilisateurs à faire confiance aux données qu'ils consomment.

b) La sécurité commence par des contrôles d'accès fins, tels que le contrôle d'accès basé sur les rôles (RBAC), afin de limiter les personnes autorisées à accéder à des données spécifiques. Le cryptage au niveau du terrain peut renforcer la protection des informations sensibles, en réduisant le risque d'exposition tout en maintenant la facilité d'utilisation.

3. Observabilité

a) Une observabilité élevée est essentielle pour surveiller l'état et le flux des données dans l'ensemble du système. Des outils tels que Stream Lineage et OpenTelemetry de Confluent offrent une visibilité sur le parcours des données, de la source à la destination. Cette transparence renforce la confiance, car les utilisateurs peuvent suivre les problèmes, examiner les données historiques et s'assurer que les données atteignent leur destination comme prévu.

4. Expérience des développeurs

a) La création d'un environnement convivial pour les développeurs est cruciale pour l'adoption. Les outils qui offrent une découverte transparente des données, comme le catalogue de données de Confluent, réduisent la friction à laquelle les développeurs sont confrontés lorsqu'ils localisent et utilisent les données. En outre, encourager un environnement collaboratif avec des normes partagées pour travailler avec des données en temps réel favorise l'innovation et aligne les équipes sur les meilleures pratiques.

Éviter les écueils courants

La création d'une plateforme de données en temps réel s'accompagne de défis qui, s'ils ne sont pas relevés, peuvent faire dérailler l'effort :

Dette technique: Ne pas tenir compte de la gouvernance ou de l'observabilité au cours des premières phases de développement peut entraîner des complications par la suite, car les consommateurs de données deviennent dépendants des mises en œuvre initiales. Évitez d'accumuler de la dette technique en mettant en œuvre ces composants dès le début.

Gouvernance réactive: Le fait d'être proactif en matière de politiques de gouvernance garantit un traitement cohérent des données dans l'ensemble de l'organisation. Une approche réactive, où les restrictions ou les politiques en matière de données ne sont appliquées qu'après l'apparition d'un problème, aboutit souvent à une gouvernance décousue ou incomplète.

Absence de normes centralisées: Lorsque des départements ou des équipes élaborent des normes distinctes en matière de traitement des données, le système qui en résulte manque de cohésion. La mise en place d'un centre d'excellence peut aider à normaliser les pratiques et à créer une stratégie de données unifiée dans l'ensemble de l'organisation.

Applications concrètes de l'architecture pilotée par les événements

Plusieurs cas d'utilisation réels mettent en évidence les avantages d'un cadre robuste axé sur les événements :

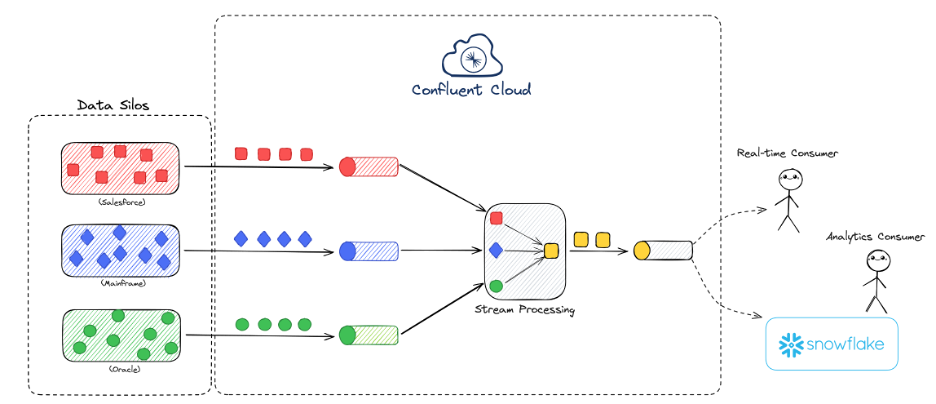

Libération des données: Le décloisonnement des données permet d'accéder en temps réel à des informations auparavant enfermées dans des départements spécifiques. Par exemple, en utilisant Confluent Cloud, les organisations peuvent agréger des données provenant de différents systèmes, transformant des sources de données fragmentées en produits unifiés et consultables. Cette approche améliore l'accessibilité des données, réduit les frais généraux associés aux connexions point à point et ouvre de nouvelles possibilités pour les charges de travail en temps réel.

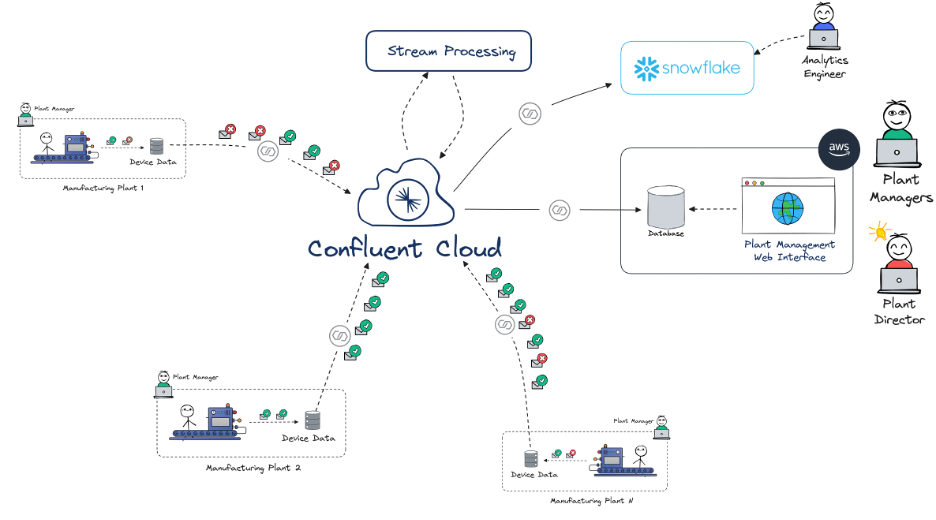

Visibilité centralisée des données: Dans la fabrication, par exemple, les usines peuvent utiliser des plateformes de données centralisées pour surveiller et analyser les performances des machines en temps réel, ce qui permet d'effectuer une maintenance prédictive et de réduire les temps d'arrêt. En intégrant les données IoT de plusieurs sites dans un flux unique et cohérent, la direction peut prendre des décisions opportunes et éclairées sur la base des dernières données disponibles dans l'ensemble du réseau de fabrication.

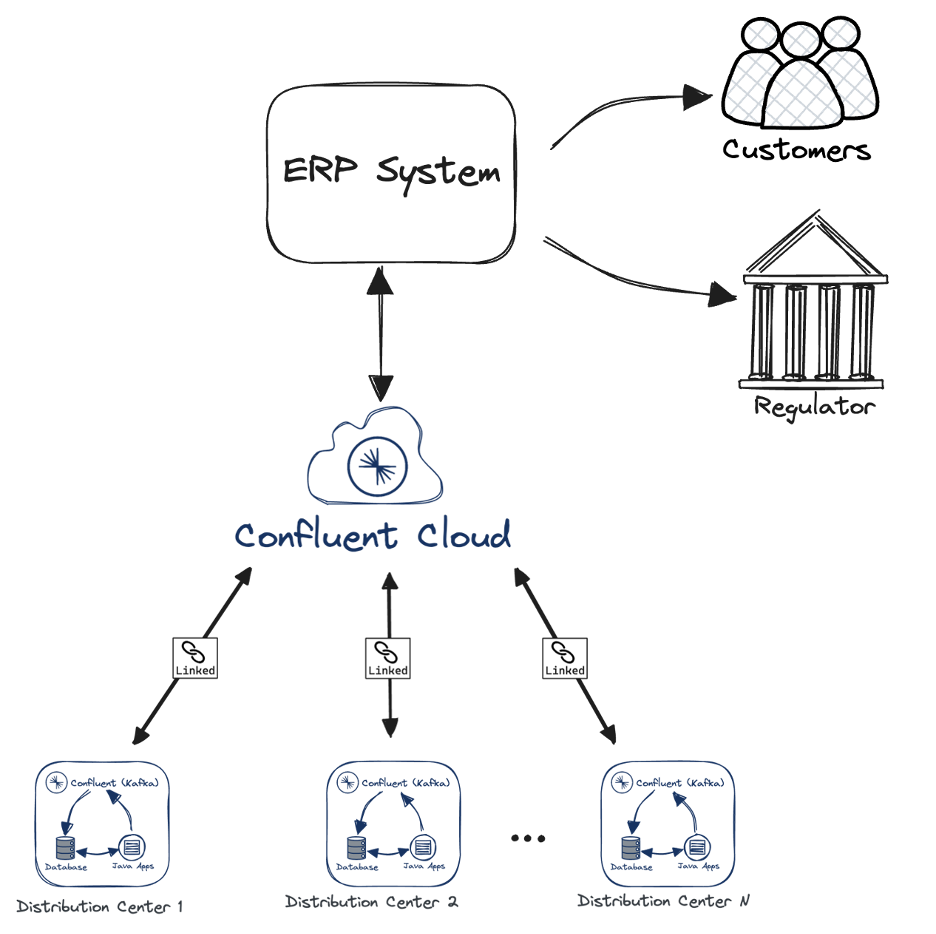

Traçabilité en temps réel: Dans le domaine de la logistique, assurer la traçabilité des produits dans les centres de distribution minimise le risque opérationnel. En utilisant des outils tels que Kafka et Confluent Cloud avec liaison de cluster, un déploiement répétable et automatisé des centres de distribution a été configuré. Une fois le déploiement effectué dans tous les centres, les entreprises peuvent suivre les mouvements des produits en temps réel, offrant une visibilité complète de la chaîne de contrôle et permettant une résolution rapide des problèmes potentiels avec une redondance complète pour éviter de perturber la continuité des activités.

Faire le premier pas

Les entreprises qui souhaitent mettre en œuvre des stratégies de données en temps réel peuvent bénéficier d'une approche structurée pour identifier et mettre en œuvre des cas d'utilisation. Commencer par un seul cas d'utilisation permet aux équipes de valider l'approche, d'évaluer son impact et d'affiner leurs processus. Au fur et à mesure que ces premiers succès démontrent leur valeur, la plateforme de données peut être étendue pour prendre en charge des cas d'utilisation plus vastes et plus complexes, créant ainsi une architecture de données résiliente, sécurisée et à l'épreuve du temps.

L'architecture de données en temps réel est un investissement dans l'agilité organisationnelle. En prenant en compte ces éléments fondamentaux (évolutivité, sécurité, observabilité et expérience des développeurs), les entreprises peuvent créer une plateforme qui non seulement répond aux besoins d'aujourd'hui, mais s'adapte également aux défis de demain.

Si vous n'avez pas pu assister à la présentation complète, n'oubliez pas d'explorer le site web de Technologie de demain. Aujourd'hui pour en savoir plus sur l'IA, les écosystèmes de données et l'ingénierie des plateformes.