Prometheus est une application utilisée pour la surveillance des systèmes et les alertes. Prometheus stocke les mesures sous forme de séries chronologiques, chaque mesure étant associée à un nom. Prometheus collecte des données à l'aide d'un modèle d'extraction, en interrogeant une liste de sources de données à une fréquence d'interrogation spécifiée. Dans Prometheus, le stockage local a une limite de taille. Dans Prometheus, le stockage peut être augment�é en utilisant des solutions de stockage à distance. L'Amazon Timestream pour LiveAnalytics permet à Prometheus d'utiliser Timestream pour LiveAnalytics comme système de stockage à distance.

En intégrant Prometheus à Timestream for LiveAnalytics, vous pouvez exploiter tout le potentiel de vos données de surveillance, ce qui vous permet de mieux comprendre le comportement du système et de prendre des décisions plus éclairées. Plus précisément, Timestream for LiveAnalytics offre les avantages suivants :

Sans serveur et évolutivité : Grâce à l'architecture sans serveur de Timestream for LiveAnalytics, stockez de grandes quantités de données de séries temporelles sans vous soucier des limites de stockage local, ce qui permet une conservation plus longue et une analyse plus complète.

Corrélation et analyse : Intégrez les données Prometheus à d'autres sources de données dans Timestream, ce qui permet d'obtenir des informations plus approfondies et d'établir des corrélations entre différents ensembles de données.

Requête SQL : Accédez rapidement aux données Prometheus et analysez-les à l'aide de SQL, ce qui simplifie l'exécution de requêtes ad hoc, la création de tableaux de bord personnalisés et l'élaboration de rapports.

Exploration améliorée des données : Utilisez les fonctions d'analyse avancées de Timestream for LiveAnalytics, telles que l'agrégation, le filtrage et le regroupement, pour mieux comprendre les performances et le comportement du système.

Rentabilité : Réduisez les coûts de stockage en transférant les données Prometheus vers une solution de stockage évolutive basée sur le cloud.

Le code source du connecteur Prometheus de Timestream for LiveAnalytics et une documentation supplémentaire sont disponibles dans le document Amazon Timestream for LiveAnalytics Prometheus Connector dans le référentiel Amazon Timestream for LiveAnalytics Prometheus Connector.

Dans cet article, nous montrons comment utiliser le connecteur Prometheus Timestream for LiveAnalytics pour utiliser Timestream for LiveAnalytics comme stockage distant pour Prometheus avec un déploiement en un clic.

Présentation de la solution

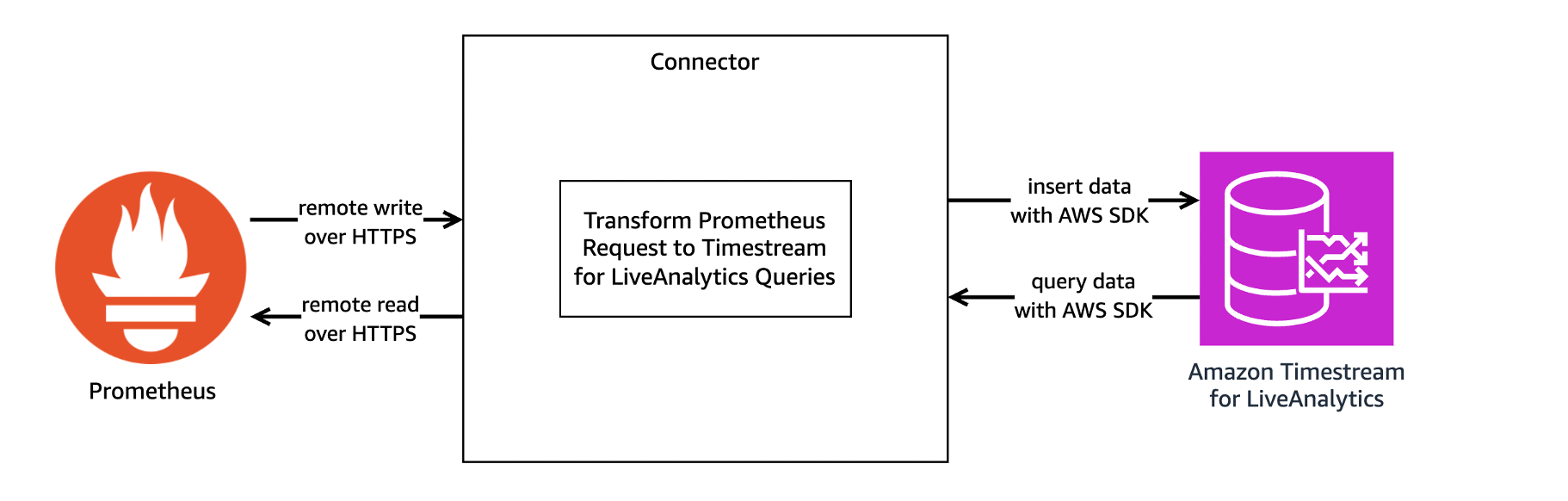

Le connecteur Prometheus Timestream for LiveAnalytics fait office de traducteur entre Prometheus et Timestream for LiveAnalytics. Le connecteur Prometheus reçoit et envoie des données de séries temporelles entre Prometheus et Timestream for LiveAnalytics par le biais des fonctions de Prometheus d'écriture et de lecture à distance de Prometheus de Prometheus. L'image suivante donne un aperçu de l'architecture du connecteur.

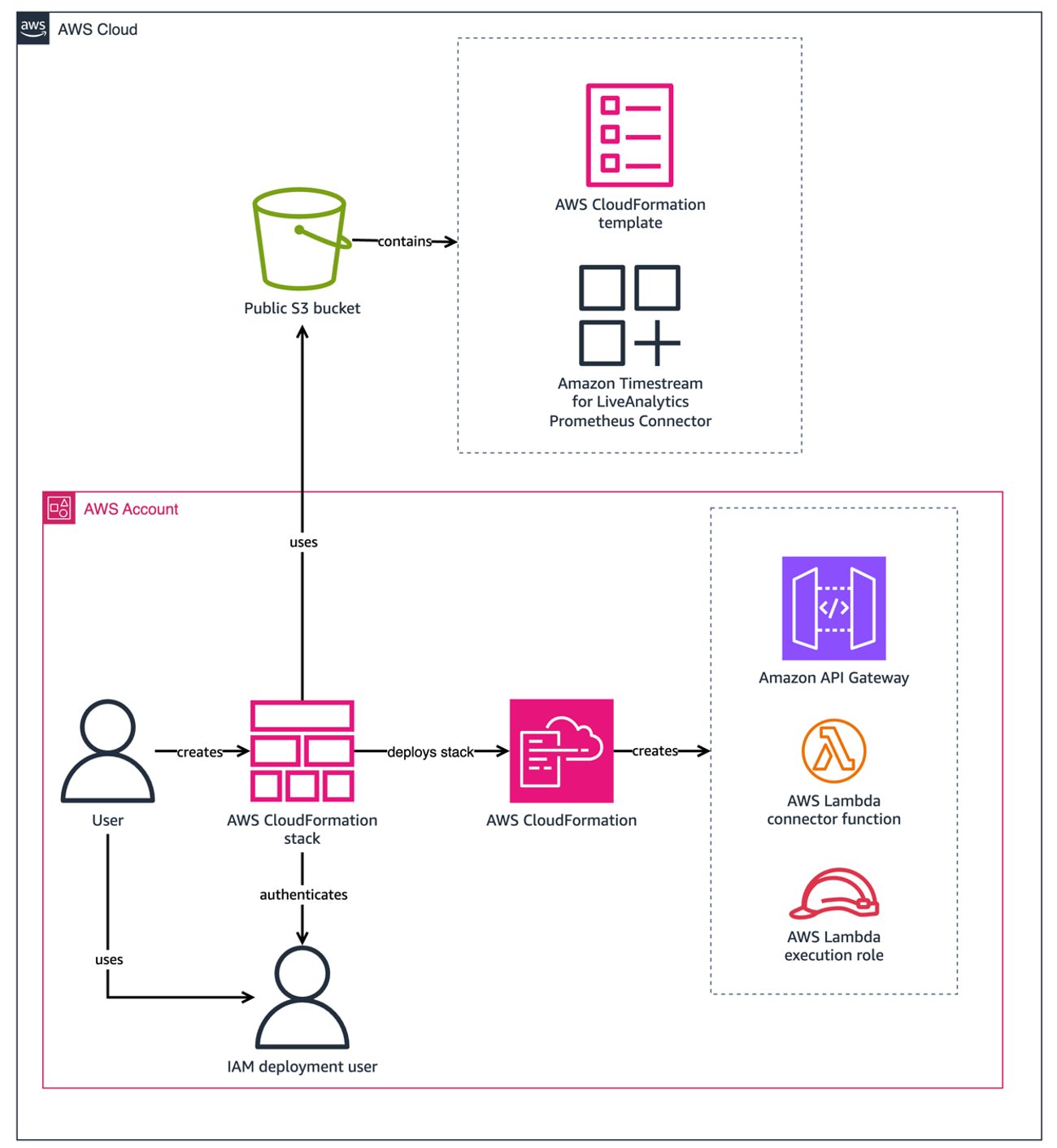

Le connecteur peut être exécuté localement, en tant que conteneur Docker ou déployé en tant qu'application AWS Lambda AWS Lambda. Cet article se concentre sur l'option recommandée, le déploiement en un clic, qui déploie le connecteur en tant que fonction Lambda à l'aide d'un fichier AWS CloudFormation AWS CloudFormation stocké dans un espace de stockage public Amazon Simple Storage Service (Amazon S3) (Amazon S3). L'image suivante donne un aperçu des ressources créées lorsque le connecteur est déployé en tant que pile CloudFormation stack avec déploiement en un clic.

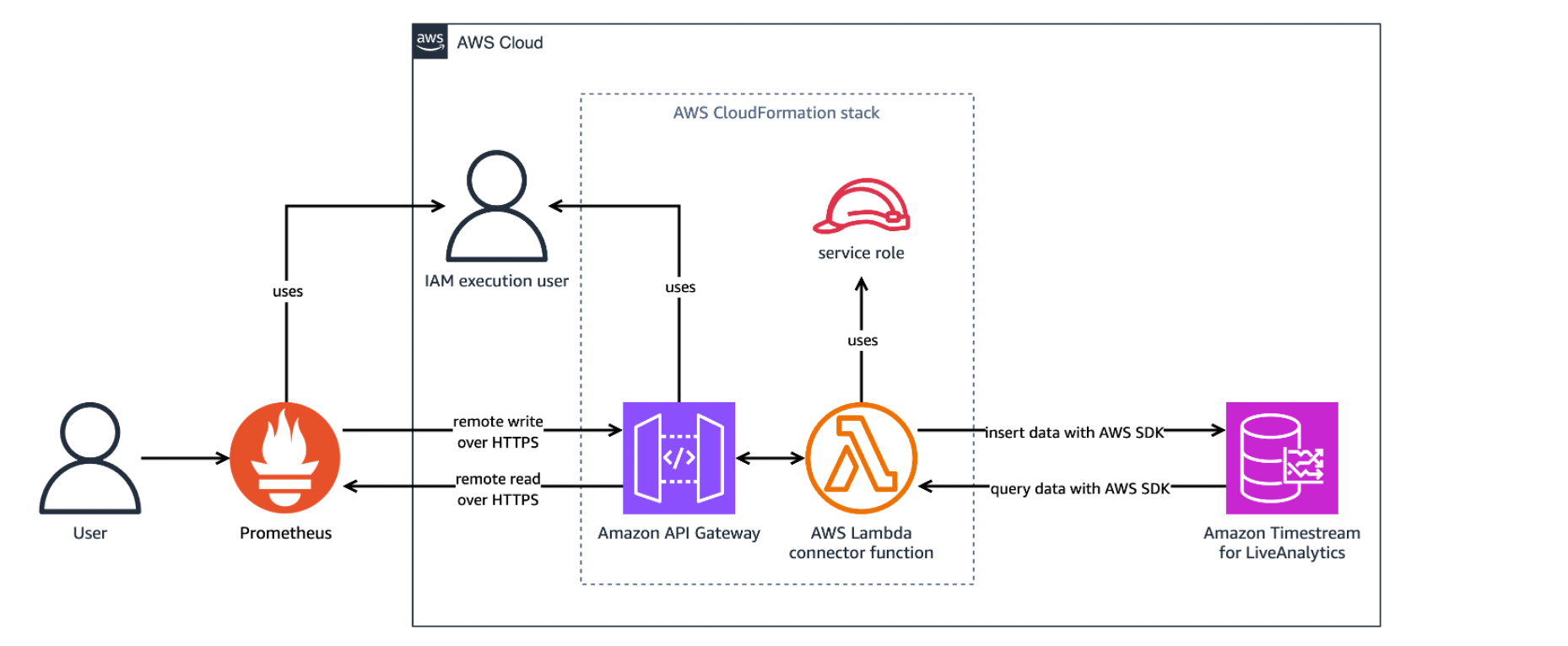

L'image suivante montre les ressources déployées par la pile CloudFormation lorsqu'elle est utilisée.

La pile CloudFormation peut prendre environ cinq minutes pour terminer la création des ressources. Vous pouvez consulter la progression dans la console AWS CloudFormation sur l'onglet Événements de la pile. Une fois la création terminée, l'état de la pile s'affiche comme suit CREATE_COMPLETE. La pile déploie les ressources suivantes :

Le connecteur Amazon Timestream for LiveAnalytics Prometheus en tant que fonction Lambda, qui agit comme une couche de traduction entre Prometheus et Timestream for LiveAnalytics.

Une Amazon API Gatewayqui achemine les demandes entrantes de Prometheus et renvoie les réponses.

Un rôle AWS IAM, utilisé pour autoriser le déploiement de la fonction Lambda et de la passerelle API.

Une politique AWS IAM, utilisée pour envoyer les journaux à Amazon CloudWatch.

La pile CloudFormation fournit les paramètres suivants :

APIGatewayStageName: Le nom d'étape par défaut de la passerelle API. La valeur par défaut est "dev".MemorySize: La taille de la mémoire en Mo de la fonction Lambda. La valeur par défaut est 512.ApiGatewayTimeoutInMillis: La durée maximale en millisecondes pendant laquelle un événement API Gateway attendra avant de s'arrêter. La valeur par défaut est 30000.LambdaTimeoutInSeconds: La durée en secondes pour exécuter le connecteur sur AWS Lambda avant l'expiration du délai. La valeur par défaut est 30.ReadThrottlingBurstLimit: Le nombre de demandes de lecture en rafale par seconde que la passerelle API autorise. La valeur par défaut est 1200.WriteThrottlingBurstLimit: Le nombre de demandes d'écriture en rafale par seconde que la passerelle API autorise. La valeur par défaut est 1200.DefaultDatabase: Nom de la base de données Prometheus par défaut. La valeur par défaut est "PrometheusDatabase".DefaultTable: Nom de la table par défaut de Prometheus. La valeur par défaut est "PrometheusMetricsTable".ExecutionPolicyName: Le nom de la politique d'exécution de base créée pour AWS Lambda. La valeur par défaut est "LambdaExecutionPolicy".LogLevel: Le niveau de sortie des journaux. Les valeurs valides sont info, warn, debug et error. La valeur par défaut est info.

Les coûts des services AWS utilisés dans cette solution sont à votre charge.

Utilisation du connecteur Prometheus Timestream for LiveAnalytics :

Cet article est destiné à servir de guide de démarrage et ne couvre pas la configuration du cryptage TLS entre Prometheus et Amazon API Gateway. Le cryptage TLS est fortement recommandé lorsque le connecteur Prometheus est déployé pour la production. Pour activer le cryptage TLS pour la production, voir Configuration de l'authentification TLS mutuelle pour une API HTTP.

Conditions préalables

Quelques conditions préalables sont requises avant d'utiliser le connecteur.

1. S'inscrire à AWS - Créez un compte AWS avant de commencer. Pour plus d'informations sur la création d'un compte AWS et la récupération de vos informations d'identification AWS, voir S'inscrire à AWS.

2. Créer un utilisateur IAM - Créez un utilisateur IAM disposant des autorisations nécessaires pour déployer le connecteur avec le déploiement en un clic. Voir la section "Configuration de l'utilisateur IAM"ci-dessous.

3. Amazon Timestream - Créez une base de données nommée PrometheusDatabase avec une table nommée PrometheusMetricsTable dans la région de déploiement cible pour Amazon Timestream for LiveAnalytics. Pour créer des bases de données et des tables dans Amazon Timestream, voir Accès à Timestream pour LiveAnalytics et la page Tutoriel Amazon Timestream pour LiveAnalytics.

4. Prometheus - Téléchargez Prometheus à partir du site téléchargement version minimale 0.0. Pour télécharger Prometheus sur un serveur Amazon Elastic Compute Cloud (Amazon EC2) utilisez wget. Par exemple, sur Amazon Linux 2023 :

wget https://github.com/prometheus/prometheus/releases/download/v2.52.0-rc.1/prometheus-2.52.0-rc.1.linux-amd64.tar.gz && \

tar -xvf prometheus-2.52.0-rc.1.linux-amd64.tar.gzPour en savoir plus sur Prometheus, consultez leur documentation d'introduction.

Configuration de l'utilisateur IAM

Afin d'utiliser Timestream for LiveAnalytics comme stockage à distance pour Prometheus, une clé d'accès doit être générée et les autorisations de déploiement et d'exécution doivent être configurées.

Clé d'accès

Une clé d'accès est nécessaire pour permettre à Prometheus de lire et d'écrire dans Timestream. L'utilisateur IAM utilisé pour l'exécution doit disposer d'une clé d'accès. Bien que l'utilisation de rôles plutôt que de clés d'accès soit une pratique exemplaire en matière de sécurité AWS, un rôle IAM ne peut pas être utilisé à la place d'une clé d'accès en raison d'une limitation de Prometheus. Le MFA n'est pas pris en charge actuellement.

Pour créer une clé d'accès

1. Accédez à la console AWS IAM.

2. Dans le volet de navigation, choisissez Gestion des accès, Utilisateurs.

3. Sélectionnez ou Créer l'utilisateur que vous souhaitez utiliser pour l'exécution dans la liste des utilisateurs.

4. Sous l'onglet Résumé sélectionnez Créer une clé d'accès.

5. Pour Cas d'utilisation sélectionner Autre et choisissez Suivant.

6. Si vous le souhaitez, donnez une description à la clé d'accès.

7. Sélectionnez Créer une clé d'accès.

8. Notez l'ID de votre clé d'accès et enregistrez votre clé d'accès secrète dans un fichier nommé secretAccessKey.txt.

Autorisations de déploiement

L'utilisateur qui déploie ce projet doit disposer des autorisations suivantes. Ces autorisations de déploiement permettent de s'assurer que la pile CloudFormation peut déployer les ressources nécessaires. Assurez-vous que les valeurs de account-id et région dans la section des ressources sont mises à jour avant d'utiliser directement ce modèle.

Remarque - Toutes les autorisations ont des ressources limitées, à l'exception des actions qui ne peuvent pas être limitées à une ressource spécifique. Les actions API Gateway ne peuvent pas limiter les ressources car le nom de la ressource est généré automatiquement par le modèle. Voir les liens de documentation suivants pour les limitations d'actions de CloudFormation, SNS et IAM : CloudFormation, SNSet IAM.

Note - Cette politique est trop longue pour être ajoutée en ligne lors de la création de l'utilisateur et doit être créée en tant que politique et attachée à l'utilisateur.

{

"Version": "2012-10-17",

"Statement": [

{

"Sid": "VisualEditor0",

"Effect": "Allow",

"Action": [

"cloudformation:ListStacks",

"cloudformation:GetTemplateSummary",

"iam:ListRoles",

"sns:ListTopics",

"apigateway:GET",

"apigateway:POST",

"apigateway:PUT",

"apigateway:TagResource"

],

"Resource": [

"arn:aws:apigateway:<region>::/apis/*",

"arn:aws:apigateway:<region>::/apis",

"arn:aws:apigateway:<region>::/tags/*"

]

},

{

"Sid": "VisualEditor1",

"Effect": "Allow",

"Action": [

"iam:GetRole",

"iam:CreateRole",

"iam:AttachRolePolicy",

"iam:PutRolePolicy",

"iam:CreatePolicy",

"iam:PassRole",

"iam:GetRolePolicy"

],

"Resource": "arn:aws:iam::<account-id>:role/PrometheusTimestreamConnector-IAMLambdaRole-*"

},

{

"Sid": "VisualEditor2",

"Effect": "Allow",

"Action": [

"cloudformation:CreateChangeSet",

"cloudformation:DescribeStacks",

"cloudformation:DescribeStackEvents",

"cloudformation:DescribeChangeSet",

"cloudformation:ExecuteChangeSet",

"cloudformation:GetTemplate",

"cloudformation:CreateStack",

"cloudformation:GetStackPolicy"

],

"Resource": [

"arn:aws:cloudformation:<region>:<account-id>:stack/PrometheusTimestreamConnector/*",

"arn:aws:cloudformation:<region>:<account-id>:stack/aws-sam-cli-managed-default/*",

"arn:aws:cloudformation:<region>:aws:transform/Serverless-2016-10-31"

]

},

{

"Sid": "VisualEditor3",

"Effect": "Allow",

"Action": [

"lambda:ListFunctions",

"lambda:AddPermission",

"lambda:CreateFunction",

"lambda:TagResource",

"lambda:GetFunction"

],

"Resource": "arn:aws:lambda:<region>:<account-id>:function:PrometheusTimestreamConnector-LambdaFunction-*"

},

{

"Sid": "VisualEditor4",

"Effect": "Allow",

"Action": [

"s3:GetObject",

"s3:GetBucketPolicy",

"s3:GetBucketLocation"

],

"Resource": "arn:aws:s3:::timestreamassets-<region>/timestream-prometheus-connector/timestream-prometheus-connector-linux-amd64-*.zip"

},

{

"Sid": "VisualEditor5",

"Effect": "Allow",

"Action": [

"s3:GetObject",

"s3:GetBucketPolicy",

"s3:GetBucketLocation",

"s3:PutObject",

"s3:PutBucketPolicy",

"s3:PutBucketTagging",

"s3:PutEncryptionConfiguration",

"s3:PutBucketVersioning",

"s3:PutBucketPublicAccessBlock",

"s3:CreateBucket",

"s3:DescribeJob",

"s3:ListAllMyBuckets"

],

"Resource": "arn:aws:s3:::aws-sam-cli-managed-default*"

},

{

"Sid": "VisualEditor6",

"Effect": "Allow",

"Action": [

"cloudformation:GetTemplateSummary"

],

"Resource": "*",

"Condition": {

"StringEquals": {

"cloudformation:TemplateUrl": [

"https://timestreamassets-<region>.s3.amazonaws.com/timestream-prometheus-connector/template.yml"

]

}

}

}

]

}

Permissions d'exécution

L'utilisateur exécutant ce projet doit avoir les permissions suivantes. Assurez-vous que les valeurs de account-id et de région dans la section des ressources soient mises à jour avant d'utiliser directement ce modèle. Si le nom de la base de données et de la table diffère de celui de la ressource de politique, veillez à mettre à jour leurs valeurs.

Note - La ressource Timestream:DescribeEndpoints doit être * comme spécifié dans security_iam_service-with-iam.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"timestream:WriteRecords",

"timestream:Select"

],

"Resource": "arn:aws:timestream:<region>:<account-id>:database/PrometheusDatabase/table/PrometheusMetricsTable"

},

{

"Effect": "Allow",

"Action": [

"timestream:DescribeEndpoints"

],

"Resource": "*"

}

]

}Ces autorisations permettent à la fonction Lambda d'écrire et de lire dans Timestream for LiveAnalytics.

Déploiement du connecteur Prometheus Timestream for LiveAnalytics en un seul clic

Utilisez un modèle AWS CloudFormation pour créer la pile. Pour installer le service Timestream for LiveAnalytics Prometheus Connector, lancez la pile AWS CloudFormation sur la console AWS CloudFormation en cliquant sur le bouton "Lancer" dans la région AWS où vous avez créé la base de données et la table Amazon Timestream for LiveAnalytics :

US East (N. Virginia) us-east-1 : VIEW, Vue dans Composer, Lancer

US East (Ohio) us-east-2 : VIEW, Vue dans Composer, Lancer

US West (Oregon) us-west-2 : VIEW, Vue dans Composer, Lancement

Asie-Pacifique (Sydney) ap-southeast-2 : VIEW, Vue dans Composer, Lancement

Asie-Pacifique (Tokyo) ap-northeast-1 : VIEW, Vue dans Composer, Lancement

Europe (Francfort) eu-central-1 : VIEW, Vue dans Composer, Lancer

Europe (Irlande) eu-west-1 : VIEW, Vue dans Composer, Lancer

Configuration de Prometheus

Pour configurer Prometheus afin qu'il puisse lire et écrire dans Timestream pour LiveAnalytics, configurez l'option remote_read et remote_write dans le fichier prometheus.ymlle fichier de configuration de Prometheus, en remplaçant les sections InvokeWriteURL et InvokeReadURL par les URL de la passerelle API du déploiement. Vous pouvez trouver prometheus.yml dans l'archive de Prometheus extraite, avec des valeurs préremplies. Si vous avez utilisé l'exemple de commande pour télécharger et exécuter Prometheus sur une instance EC2 Amazon Linux 2023 dans la section Prérequis ci-dessus, prometheus.yml se trouve dans ~/prometheus-2.52.0-rc.1.linux-amd64/.

Pour trouver l'élément InvokeWriteURL et InvokeReadURL:

1. Ouvrez la console console AWS CloudFormation.

2. Dans le volet de navigation, choisissez Piles.

3. Sélectionnez PrometheusTimestreamConnector dans la liste des piles du volet de navigation Piles

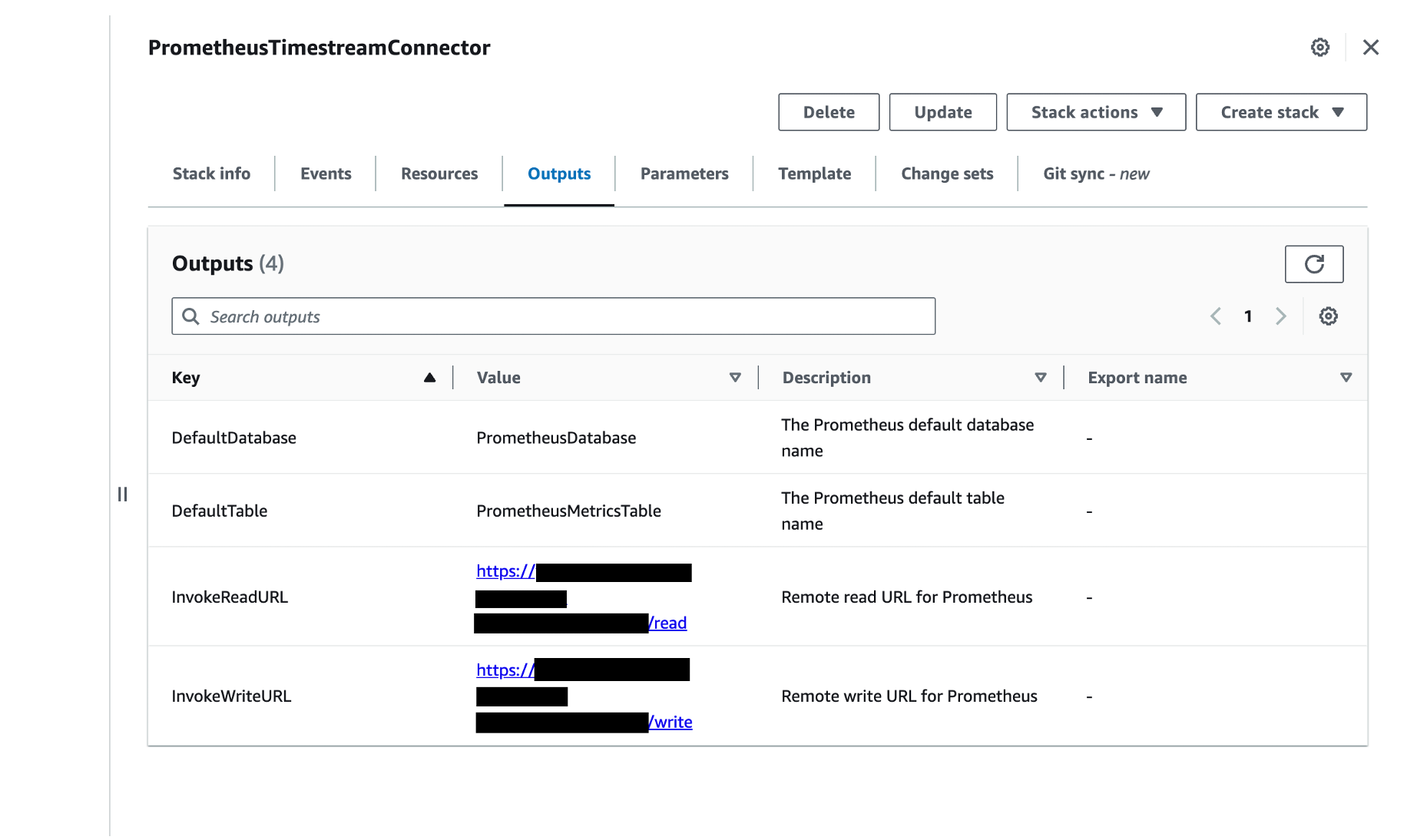

4. Choisissez l'option Sorties La capture d'écran suivante montre les Sorties avec InvokeReadURL et InvokeWriteURL affichés comme sorties :

Pour mettre à jour prometheus.yml

1. Ajoutez la section remote_write pour fournir l'URL à laquelle Prometheus enverra les échantillons. Remplacez InvokeWriteURL par l'URL InvokeWrite que vous avez trouvée ci-dessus et mettez à jour les fichiers username et password_file avec un ID de clé d'accès IAM valide et un fichier contenant une clé d'accès secrète IAM valide.

remote_write:

- url: "InvokeWriteURL"

queue_config:

max_samples_per_send: 100

basic_auth:

username: accessKey

password_file: /Users/user/Desktop/credentials/secretAccessKey.txt2. Ajoutez l'élément remote_read pour indiquer l'URL à laquelle Prometheus enverra les demandes de lecture. Là encore, remplacez InvokeReadURL par l'URL InvokeReadURL que vous avez trouvée ci-dessus et mettez à jour le nom d'utilisateur et le fichier de mot de passe avec un ID de clé d'accès IAM valide et un fichier contenant une clé d'accès secrète IAM valide.

remote_read:

- url: "InvokeReadURL"

basic_auth:

username: accessKey

password_file: /Users/user/Desktop/credentials/secretAccessKey.txtPour en savoir plus, consultez la page lecture à distance et écriture à distance sur la page de configuration de Prometheus.

Le fichier fichier_mot_de_passe doit être le chemin absolu du fichier, et le fichier de mot de passe ne doit contenir que la valeur de la clé d'accès aws_secret_access_key. Pour d'autres méthodes de configuration de l'authentification, voir la section Configuration Prometheus dans la documentation du connecteur.

NOTE : Nous recommandons d'utiliser le nombre par défaut d'échantillons par requête d'écriture via max_samples_per_send. Pour plus de détails, voir la section Nombre maximal d'échantillons Prometheus par demande d'écriture à distance dans la documentation du connecteur.

Démarrer Prometheus

1. Assurez-vous que l'utilisateur qui invoque la fonction AWS Lambda dispose d'autorisations de lecture et d'écriture sur Amazon Timestream. Pour plus de détails, voir la section Permissions d'exécution dans la documentation du connecteur.

2. Démarrez Prometheus en passant au répertoire contenant le binaire Prometheus et en l'exécutant. Par exemple :

./prometheus --config.file=prometheus.yml # Start prometheus on localhost:9090Étant donné que les options de stockage à distance pour Prometheus ont été configurées, Prometheus commencera à écrire sur Timestream via le point de terminaison d'écriture API Gateway.

Vérifier le fonctionnement du connecteur Amazon Timestream for LiveAnalytics Prometheus

1. Pour vérifier que Prometheus est en cours d'exécution, ouvrez http://localhost:9090/ dans un navigateur. Cela permet d'ouvrir le navigateur d'expression de PrometheusSi vous exécutez Prometheus sur une instance EC2, après avoir autorisé le trafic TCP sur le port 9090, le navigateur d'expression de Prometheus sera accessible à l'adresse suivante http://<EC2 instance public IP or DNS>:9090.

2. Pour vérifier que le connecteur Prometheus est prêt à recevoir des demandes, assurez-vous que le message suivant est imprimé dans les journaux de la fonction Lambda dans la console console Amazon CloudWatch. Voir la section Dépannage dans la documentation du connecteur pour d'autres messages d'erreur.

level=info ts=2020-11-21T01:06:49.188Z caller=utils.go:33 message="Timestream <write/query> connection is initialized (Database: <database-name>, Table: <table-name>, Region: <region>)"

3. Pour vérifier que le connecteur Prometheus écrit des données :

Ouvrez la console Amazon Timestream.

Dans le volet de navigation, sous LiveAnalytics, choisissez Outils de gestion, Éditeur de requêtes.

Saisissez la requête suivante : SELECT COUNT() FROM PrometheusDatabase.PrometheusMetricsTable

Sélectionnez Exécuter.

Un nombre unique, indiquant le nombre de lignes écrites par Prometheus, sera renvoyé sous Résultats de la requête. Les requêtes Timestream for LiveAnalytics peuvent également être exécutées à l'aide de la commande AWS CLI suivante :

aws timestream-query query --query-string "SELECT COUNT() FROM PrometheusDatabase.PrometheusMetricsTable"La sortie devrait ressembler à ce qui suit :

{

"Rows": [

{

"Data": [

{

"ScalarValue": "340"

}

]

}

],

"ColumnInfo": [

{

"Name": "_col0",

"Type": {

"ScalarType": "BIGINT"

}

}

],

"QueryId": "AEBQEAMYNBGX7RA"

}Cet exemple de résultat indique que 340 lignes ont été ingérées. Votre nombre sera probablement différent.

4. Pour vérifier que le Prometheus Connector peut interroger les données d'Amazon Timestream, consultez le site suivant http://localhost:9090/ dans un navigateur, ce qui ouvre le de Prometheuset exécutez une requête Prometheus Query Language (PromQL). Si vous exécutez Prometheus sur une instance EC2, rendez-vous à l'adresse suivante http://<EC2 public IP or DNS>:9090 pour accéder au navigateur d'expression de Prometheus. La requête PromQL utilisera les valeurs de default-database et default-table comme étant la base de données et la table correspondantes qui contiennent les données. Voici un exemple simple :

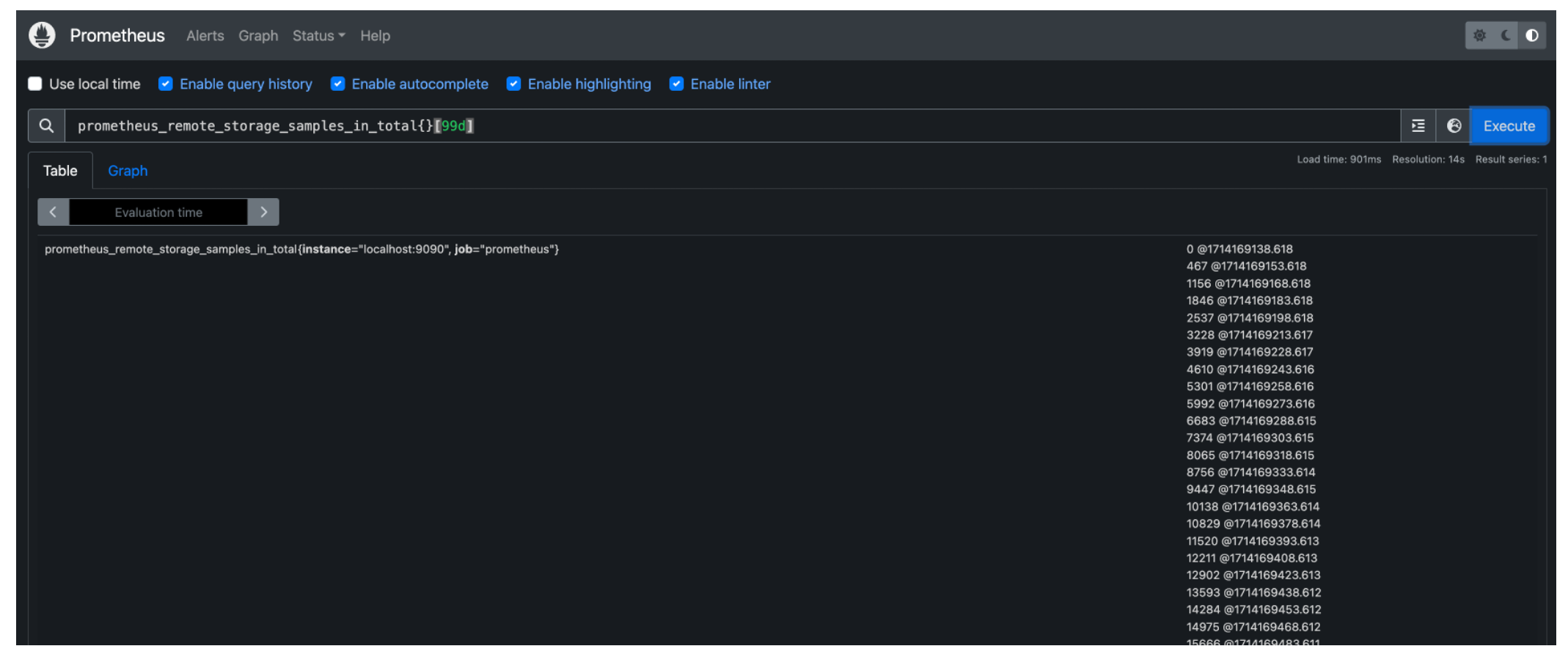

prometheus_remote_storage_samples_in_total{}[99d]prometheus_remote_storage_samples_in_total est un nom de métrique. La base de données et la table interrogées sont la base de données et la table par défaut correspondantes. base de données par défaut et table par défaut configurées pour le connecteur Prometheus. Cette requête PromQL renverra les données de la série temporelle des quatre-vingt-dix-neuf derniers jours avec le nom de la métrique prometheus_remote_storage_samples_in_total dans tableau par défaut de base de données par défaut. La capture d'écran suivante montre le résultat de cette requête dans Prometheus.

PromQL prend également en charge les expressions rationnelles. La requête suivante renvoie les lignes de PrometheusMetricsTable de PrometheusDatabase où :

la colonne nom de la métrique est égale à

prometheus_remote_storage_samples_in_total;L'instance de la colonne correspond au motif regex

.*:9090.la colonne job correspond au motif regex

p*.

prometheus_remote_storage_samples_in_total{instance=~".*:9090", job=~"p*"}[99d]Pour plus d'exemples, voir Exemples de requêtes Prometheus. Il existe d'autres moyens d'exécuter des PromQL, notamment par l'intermédiaire de l'API HTTP API de Prometheus ou Grafana.

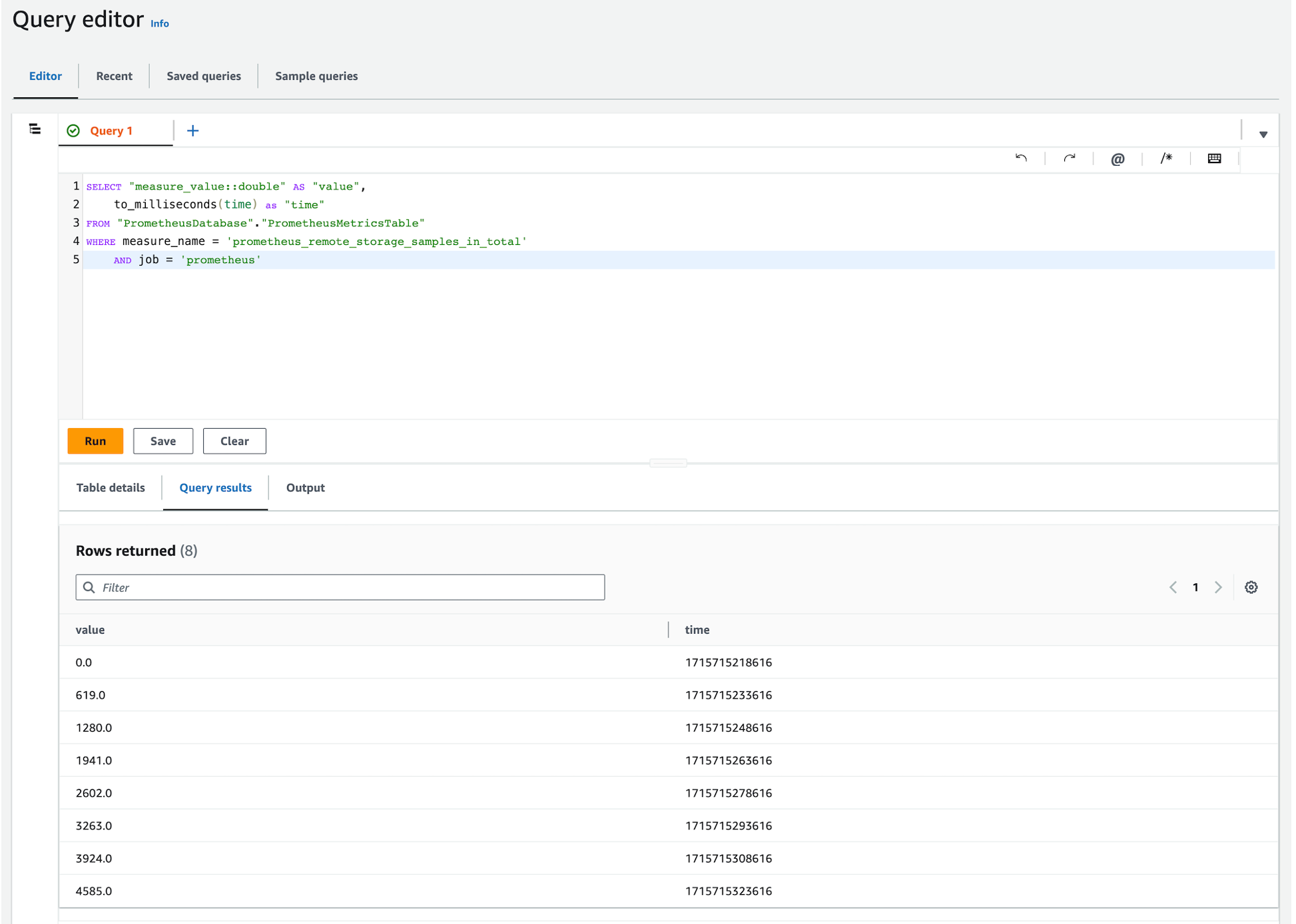

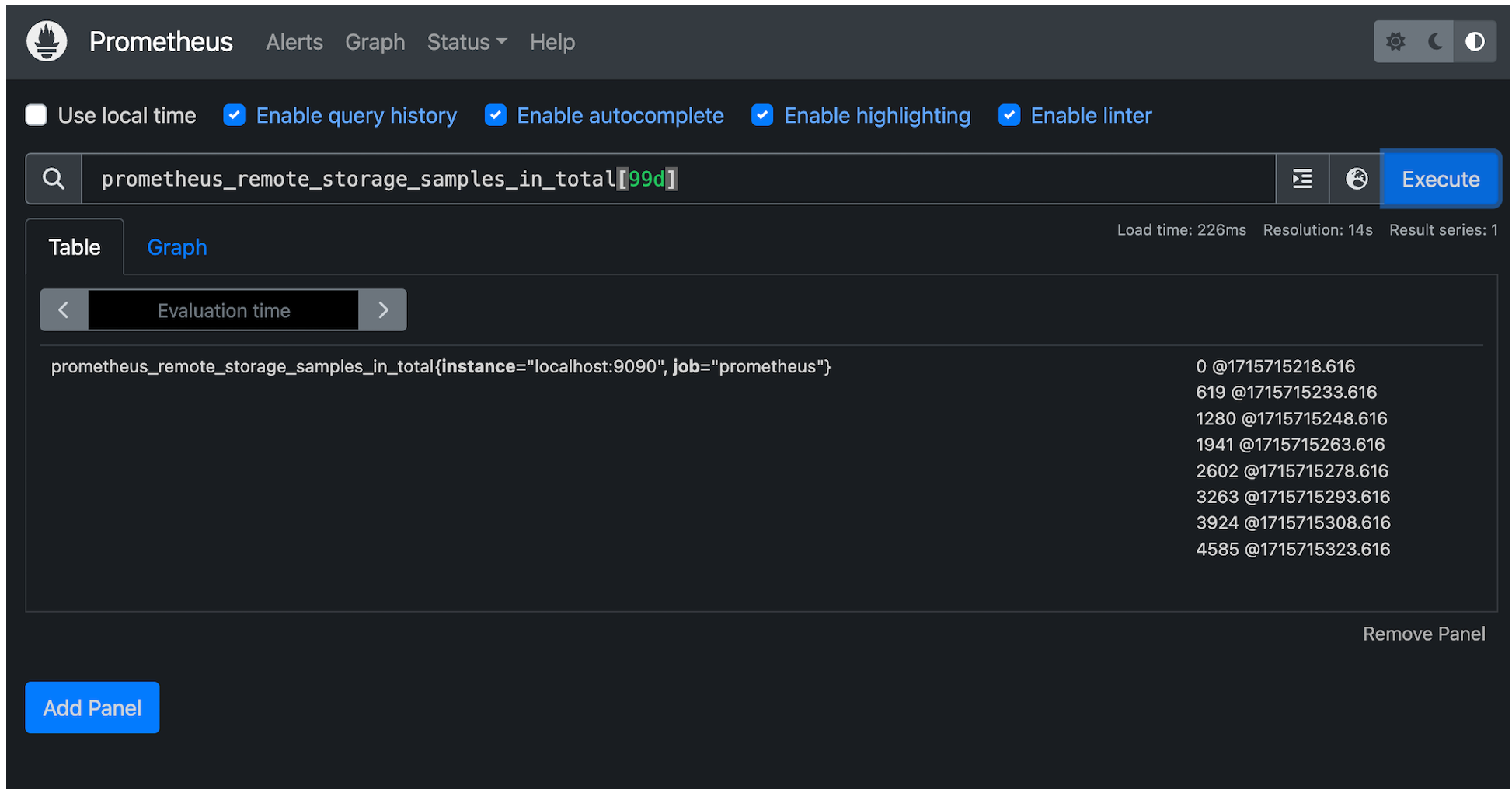

En utilisant les méthodes ci-dessus et en modifiant la requête Timestream for LiveAnalytics pour formater les résultats de manière similaire à Prometheus, les requêtes suivantes ont été exécutées dans Timestream for LiveAnalytics et Prometheus, vérifiant ainsi les données ingérées.

Requête Timestream for LiveAnalytics

Requête Prometheus

Nettoyage

Si vous avez suivi les étapes de cet article, vous avez créé un certain nombre de ressources AWS. Pour éviter les coûts, supprimez ces ressources si elles ne sont plus nécessaires.

Supprimer Timestream pour les bases de données LiveAnalytics.

1. Ouvrez la console console Amazon Timestream.

2. Dans le volet de navigation, sous LiveAnalyticschoisissez Ressources, Bases de données.

3. Sélectionnez la base de données que vous avez créée pour que le connecteur l'utilise.

4. Choisissez l'option Tables

5. Sélectionnez chacune des tables de votre base de données, puis choisissez Supprimer.

6. Tapez supprimer pour supprimer le tableau.

7. Une fois que toutes les tables de la base de données ont été supprimées, sélectionnez Supprimer.

8. Tapez supprimer pour supprimer votre base de données.

Supprimer le flux temporel pour LiveAnalytics Prometheus Connector CloudFormation Stack.

1. Ouvrez la console AWS CloudFormation.

2. Dans le volet de navigation, choisissez Piles.

3. Sélectionnez la pile utilisée pour déployer le connecteur Prometheus Timestream for LiveAnalytics. PrometheusTimestreamConnector.

4. Choisissez Supprimer et Supprimer dans la fenêtre contextuelle pour supprimer la pile CloudFormation et ses ressources associées.

Conclusion

Dans ce billet, nous avons montré comment utiliser le connecteur Prometheus Timestream for LiveAnalytics pour lire et écrire des données de séries temporelles Prometheus avec Timestream for LiveAnalytics via les API remote_read et remote_write de Prometheus.

Dans le référentiel du connecteur, les limites du connecteur sont documentées dans le fichier README.md#limitations et les mises en garde sont documentées dans README.md#caveats et serverless/DEVELOPER_README.md#caveats.

Si vous ne l'avez pas encore fait, commencez à configurer le connecteur en consultant la section ci-dessus intitulée Utilisation du connecteur Prometheus Timestream for LiveAnalytics ou en visitant le site web awslabs/amazon-timestream-connector-prometheus.

*Cet article est le fruit d'une collaboration entre Improving et AWS et est publié sur les deux blogs suivants blog d'Improving et sur le AWS Database Blog.